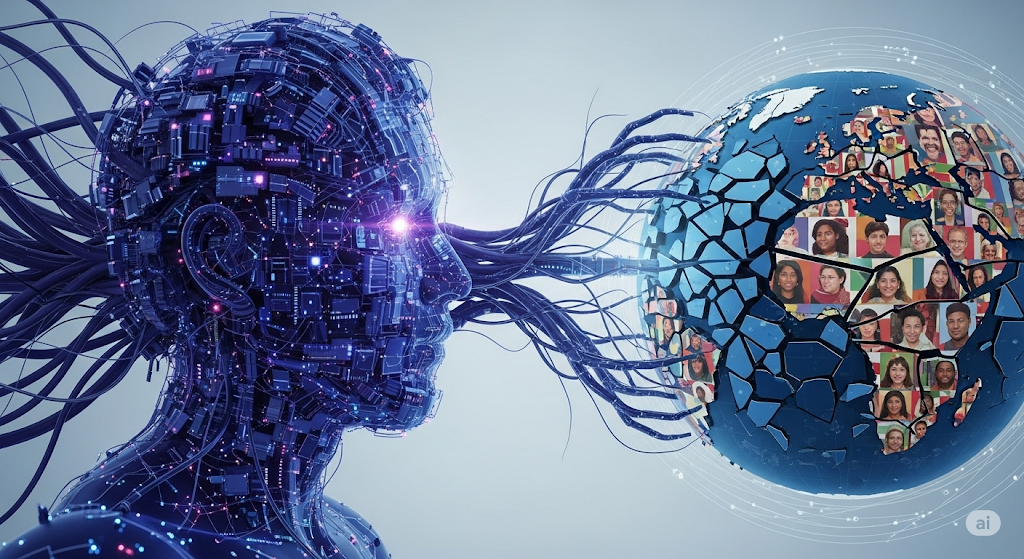

【ivendor編輯中心 / 2025年6月25日】能力與信任的巨大鴻溝 進入2025年,人工智慧(AI)已深度融入全球職場與日常,然而其技術的飛速發展與公眾的信任之間,正浮現一道巨大的鴻溝。根據2025年5月最新發布的《全球人工智慧信任、態度與應用調查報告》,儘管全球有66%的受訪者規律性地使用AI,但僅有46%的人表示願意信任AI系統。這份涵蓋47國、超過4.8萬名受訪者的研究揭示了一個核心矛盾:人們享受AI帶來的便利,卻對其決策的可靠性與安全性抱持深刻疑慮。在此背景下,全球七成的公眾呼籲建立國家級乃至國際級的AI治理框架,使得「AI治理」不再是技術圈的空談,而是維繫社會穩定的關鍵議題。 AI治理的核心:從抽象原則到具體實踐 可信賴的AI治理並非單一的技術問題,而是一個涵蓋技術、流程與法規的系統性工程。綜合近期研究,其核心實踐可歸納為以下幾點:

- 透明度與可解釋性 (XAI):隨著AI模型日益複雜,其「黑盒子」特性引發了對公平與問責的擔憂。可解釋性AI(XAI)的崛起,正是為了解決此問題,它旨在提供清晰的技術與方法,讓使用者能理解AI為何及如何做出特定決策。這對於需要驗證AI決策並確保其符合道德與法律標準的開發者、監管者和企業領袖至關重要。

- 公平性與偏見緩解:AI的偏見源自於數據與演算法,若不加以控制,可能導致歧視性的招聘或不公平的信貸審核。為此,權威機構正推出具體的指導原則。例如,美國醫療保健研究與品質局(AHRQ)在2025年第二季發布了新框架,提供識別、衡量和緩解AI風險預測工具中偏見的具體步驟。這標誌著偏見緩解已從理論探討,走向有明確指引的實務操作。

- 安全性與穩健性:保護AI系統免受惡意攻擊與濫用,是治理的關鍵一環。近期法規更新特別強調了對網路安全的強化要求。同時,大型AI服務提供商也開始強制要求開發者遵守其「可接受使用政策」,禁止將AI用於惡意假冒、政治微觀鎖定或散播不實資訊等高風險行為。

- 問責制與獨立監督:當AI出錯時,責任誰屬?對此,產業的共識是需要建立獨立的監督與驗證機制。根據PwC的2025年AI商業預測,企業應從風險最高的領域著手,建立一套獨立且可持續的驗證流程。這可以來自於內部稽核團隊,或引入第三方專家,以確保AI的治理與控制是客觀且有效的。

全球治理現況:法規加速落地與挑戰 2025年第二季,全球AI監管進入了加速落地期,呈現出清晰的行動路徑: 高風險應用禁令生效:歐盟的《人工智慧法案》第一階段已開始實施,明確禁止了部分高風險AI應用,例如:由公共機構進行的社會評分、利用潛意識技術扭曲人類行為,以及在公共場所進行無差別的即時遠端生物辨識。

通用模型納入監管:針對能力強大的通用AI模型(如GPT-4),監管機構已提出七項關鍵義務的初步指南,包括風險評估與緩解、模型評估測試、文件與透明度要求,以及網路安全保護措施等。

強制性事故報告機制:為了讓政策制定者能有效追蹤AI風險趨勢並協調應對,建立AI相關事故(如偏見事件、安全漏洞)的強制性報告制度已成為新的治理重點。

以當責治理,回應信任的呼喚 綜合近期發展,全球AI產業正站在一個關鍵的十字路口。技術的進步已毋庸置疑,但信任的赤字卻日益擴大。從國際組織的倫理倡議,到各國具體的法規實施,再到企業內部建立的獨立監督機制,一個多層次、跨領域的AI治理體系正在形成。未來,能夠在市場中勝出的,將不再只是技術最先進的企業,更是那些能夠透過具體、可驗證的治理行動,向世界證明其AI值得信賴的企業。唯有如此,才能回應社會的深切期盼,真正釋放AI對人類社會的正面潛力。